오늘은 교차엔트로피 목적함수와

베르누이 확률분포를 통한 유도방법을 정리해보고자 한다.

우선 교차엔트로피 목점함수는 아래와 같다.

교차엔트로피 목적함수를 유도하기 위해서는 베르누이 확률분포를 먼저 이해하면 좋다.

베르누이 확률분포에 대한 설명이다.

베르누이 확률분포는 실험결과가 두 가지 중에 하나로 나오는 시행으로

예를 들어 성공 vs. 실패 와 같은 예시를 들 수 있다.

이걸 식으로 표현 해보면,

P(x=1) = p, P(x=0) = 1-p 이다.

위의 식이 뜻하는 것은

성공할 확률(x=1)을 p라고 하면

실패할(x=0) 확률은 1-p이다.

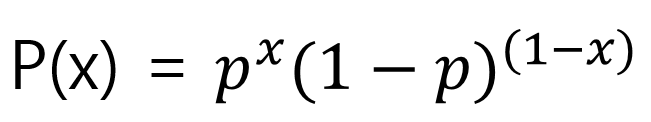

그러므로 그에 따른 확률분포는 아래와 같다.

다시 한번 예시로 설명해보자면, x=1을 대입하면 아래와 같은 값이 나오고,

x=0을 대입하면 아래와 같이 1-p가 되어 우리가 알고있는 성공 vs.실패를 정의하는 확률분포라 할 수 있다.

그러므로 likelihood함수는 아래와 같고

Log Likelyhood함수는 아래와 같다.

위의 식을 보면 가장 처음에 말했던 교차엔트로피 목적함수와 유사하다는 걸 알 수 있다.

차이점이라고 한다면, 앞에 음수가 붙었다는 차이인데

결국 이 말은, logistic regression에서 Log Likelihood를 최대화 하는 것이 Cross Entropy를 최소화 하는 것과

확률적 관점에서 완벽하게 같은 의마가 되는 것이다.

그러므로 베르누이 분포에서와 같이,

교차엔트로피 목적함수는 binary classification에서 주로 사용하는 목적함수인 것이다.

다음 글에서는,

Binary Classification에서 사용하는 목적함수의 다음인

Multi Classification에서 사용하는 목적함수에 대해서 정리할 것이다.

'IT > 머신러닝(수업)' 카테고리의 다른 글

| 배치 정규화 (0) | 2021.11.15 |

|---|---|

| 가중치 초기값- He, Xavier initialization (0) | 2021.11.14 |

| 6가지의 activation function과 7가지의 optimizer (0) | 2021.10.25 |

| 로그우도 목적 함수와 multi-class classification (0) | 2021.10.08 |

| 목적함수에 대한 정리 (0) | 2021.09.29 |