정규분포(가우시안분포)

정규분포(가우시안분포)는 parametric density function임

→ 평균과 분산으로 표현이 가능함

** 가우시안 x 가우시안 = 가우시안

( 계산에 유리함)

d-dimension에서 ∑ 는 공분산을 뜻함

σ의 제곱 = ∑

이 전장에서 배웠던 우도함수 참고하기..

위의 식에서 양변에 로그를 취함

gi(x)는 변수 x에 대한 2차 식

→ Why? X(transpose) * X 식이므로

역행렬 공식 참고**

https://blog.naver.com/suhan80/222697306428

결정경계(decision boundary)

gi(x)=gj(x)인 점

즉, gij(x)=0인

분별함수 특이상황

- 공분산 행렬이 같은 상황 (문제를 간단하게 하기위해서도 씀)

따라서 2차항이 없어짐

선형식이 됨 → 선형 결정경계가 되어 간단해짐

위의 식에서 gj(x)를 추가하여 결정경계를 확인하면

아래와 같이 j term이 추가가 됨

** 공분산(∑) 의 transpose는 그대로 공분산임(대칭행렬이므로)

** 공분산 구하는 방법

P31에 있는 예제 직접 계산하는거 시험

P(w1) > P(w2) 이면 결정경계가 흰점으로 이동

(흰점쪽으로 결정경계가 이동 = 검은점의 영역이 커짐)

위의 그림에서 사전확률이 달라질때 decision boundary가 어떻게 변하는지 알수 있어야함

P(w1) > p(w2)일 때 움직이는 방향 문제나옴!

공분산이 다른 경우

2차식으로 표현이 되며 결정경계는 곡선으로 나타남

P(w1)이 커지면 decision boundary가 어떻게 변하게 되는지 알 수 있어야함

최소 거리 분류기

좌변이 음수이므로 좌변이 작아져야 우변이 커짐

이때, 최소거리 분류기를 보면

page 26의 식2.34를 보면 (2.41)과 같이 간소화 시킬 수 있고

좌변이 작아져야 되므로 argmin을 사용할 수 있음

참고로 좌변의 값은 마할라노비스 거리계산 식과 같다는 것을 사용

마할라노비스 거리 직접 계산하기 중요함

유클리디안 거리, 마할라노비스 거리 설명

분산을 포함하여 거리를 계산하는것 = 마할라노비스 거리

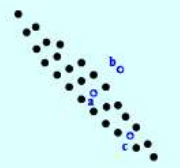

위의 그림에서 b라는 sample은 실제 해당 분산(a) 과 유클리디안 거리로 봤을 때,

b보다 멀다고 할 수 있지만 마할라노비스 거리로 봤을 때는

해당 분포에 속하므로 거리가 b보다 가깝다고 할 수 있음

나이브 베이지안 분류기

σij = 0 즉, 특징들이 서로 독립이라는 가정

= covariance maxtrix에서 대각원소값을 제외한 모든 값이 0이라는 가정임

= (iid를 가정함: independent and identically distributed)

그래서 각각 곱하기로 아래와 같이 표현할 수 있음

단점: 성능이 저하될 수 있음

장점: 차원의 저주를 피함

기각 처리